Les dernières avancées dans le domaine de l’intelligence artificielle permettent de produire des fausses nouvelles plus facilement et plus rapidement. Mais la même technologie permettrait-elle de détecter des fausses nouvelles plus facilement et plus rapidement, s’est demandé le Détecteur de rumeurs ?

Vérifier si une affirmation douteuse est vraie ou fausse, revenir à la source pour dégager les faits des opinions, peut prendre beaucoup de temps, comme les journalistes peuvent en témoigner. C’est pourquoi certains informaticiens prétendent que l’intelligence artificielle (IA) pourrait automatiser une partie de la démarche.

En effet, si ces agents conversationnels ou grands modèles de langage (LLM) dont on parle beaucoup depuis l’an dernier, ont cette capacité à fournir, dans un langage compréhensible, des réponses à des requêtes comportant un grand nombre de paramètres, ils pourraient, en théorie, déterminer si une allégation est vraie ou fausse.

L’IA limitée par ses connaissances

Mais ce n’est pas aussi simple, même pour un ordinateur. Si on demande à une telle IA de vérifier un fait, elle cherchera d’abord dans les connaissances qu’elle a acquises lorsqu’elle a été développée —c’est-à-dire la base de données à laquelle on lui a donné accès. Ce qui distingue les différents agents conversationnels comme ChatGPT (Open AI), Gemini (Google), Bing AI (Microsoft) et Llama (Meta), ce sont donc les données utilisées pour les entraîner. Par exemple, dans une étude réalisée en 2023, un chercheur de l’Université du Wisconsin avait montré que la version 4.0 de ChatGPT obtenait de meilleurs résultats que Gemini ou Bing dans la vérification de faits .

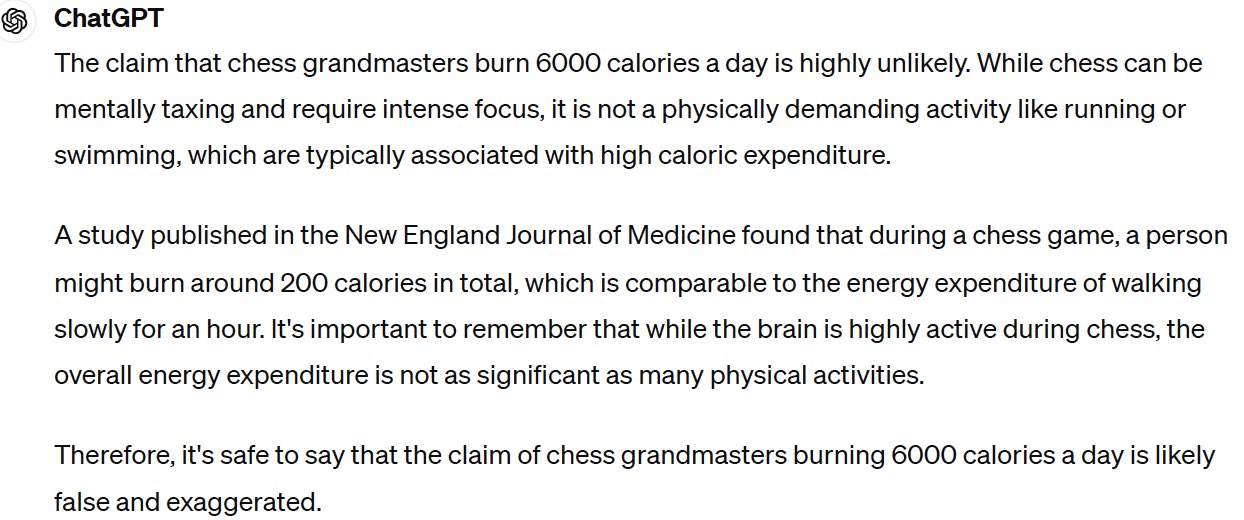

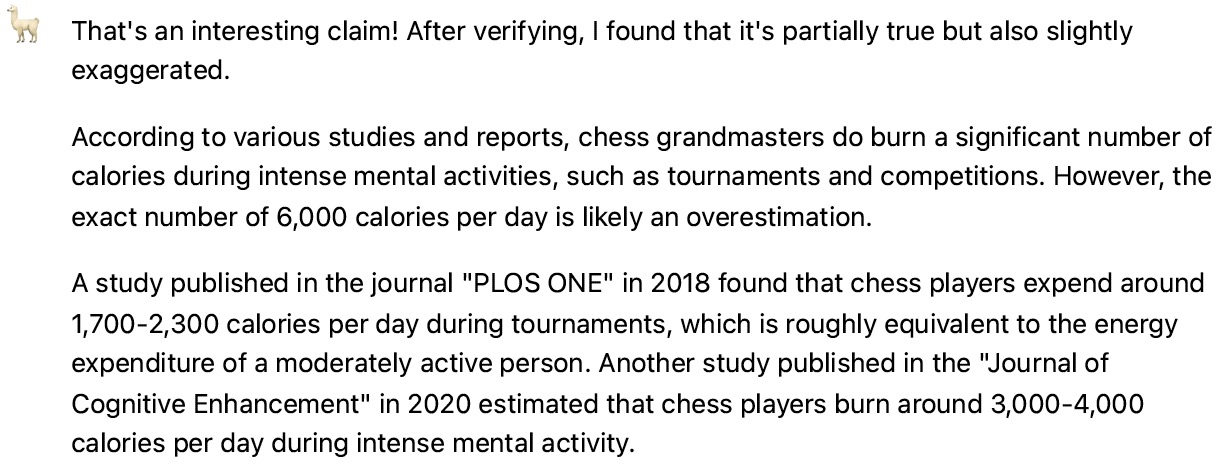

Le Détecteur de rumeurs a d’ailleurs demandé à Chat GPT 3.5 et à Llama d’examiner une rumeur qu’il avait lui-même déboulonnée dernièrement: les grands joueurs d’échecs dépensent-ils 6000 calories par jour?

Alors que ChatGPT a conclu que cette affirmation était hautement improbable, Llama a répondu qu’elle était partiellement vraie, mais « légèrement exagérée ». Le problème est que, dans les deux cas, les IA ont inventé des études pour appuyer leur verdict. Un « comportement » qui n’est pas si surprenant, puisqu’il a été observé à maintes reprises depuis l’an dernier.

Comment entraîner l’IA à la vérification de faits

Pour rendre les résultats d’un chatbot plus fiables, il serait en théorie possible de l’entraîner à partir de bases de données spécialisées. Créer ces outils n’est toutefois pas une mince tâche.

Par exemple, la banque de données FEVER (Fact Extraction and VERification), développée en 2018, est composée de près de 200 000 allégations fabriquées artificiellement à partir de Wikipédia. Chacune a été générée en altérant des passages extraits de l’encyclopédie et a ensuite été vérifiée par des humains, qui ignoraient la formulation d’origine. L’allégation a ainsi été associée à un verdict (soutenue, réfutée ou information insuffisante) ainsi qu’à une phrase expliquant le résultat.

Il existe également des bases de données composées d’allégations récoltées directement sur des sites de vérifications de faits. Par exemple, en 2022, un ingénieur de la Californie en a développé à partir de 21 152 affirmations évaluées par le média américain PolitiFact entre 2008 et 2022. Chaque affirmation est classée dans l’une des six catégories utilisées par PolitiFact: vrai, plutôt vrai, à moitié vrai, plutôt faux, faux ou mensonge éhonté (« pants on fire »). De la même façon, en 2023, des scientifiques de l’Université de Copenhague ont créé une banque de données qui comporte 34 918 allégations recueillies sur 26 sites internationaux de vérification de faits.

C’est en partie la stratégie utilisée par le site ClaimBuster qui vérifie d’abord les allégations qu’on lui soumet, dans sa propre banque de données, qui est composée de d’affirmations provenant des débats entre les candidats à la présidence des États-Unis, entre 1960 et 2016.

Chercher le web

Le problème avec ces banques de données, c’est qu’elles sont dépendantes du travail qu’ont eu le temps de faire les humains qui sont derrière ces sites. S’il s’agit d’une allégation trop récente pour avoir été vérifiée, la base de données ne sera d’aucune utilité. Cela dépend aussi des sites qui ont été utilisés pour nourrir cette base de données. Par exemple, le Détecteur de rumeurs a demandé à ClaimBuster de déterminer s’il est vrai que les feux de forêt canadiens ont émis autant de carbone que les humains en 100 ans, une fausse allégation qui circulait l’été dernier. Le site n’a repéré aucune information à ce sujet dans sa banque de données, alors que le Détecteur de rumeurs y avait consacré un article en septembre 2023.

Ces bémols expliquent pourquoi certaines applications de vérification de faits ajoutent une étape, où l’IA parcourt le web pour récolter des informations complémentaires. Ainsi, des chercheurs de l’Université de Zurich ont exploré, dans un article de 2024, le potentiel des LLM pour la vérification de faits. Or, dans leur cas, l’algorithme faisait une requête sur Google et retournait les dix premiers résultats trouvés. Il décidait ensuite si ceux-ci étaient suffisants pour répondre à la question ou s’il fallait procéder à une nouvelle recherche. Malgré cela, concluaient-ils, les résultats de ces vérifications n’étaient pas toujours exacts.

La stratégie d’une requête Google est vraisemblablement utilisée par la plus récente application de vérification de faits de Originality.ai. Lorsque le Détecteur de rumeurs a voulu tester l’affirmation sur les joueurs d’échecs, les trois sources citées pour justifier le verdict provenaient des quatre premiers résultats obtenus en faisant la même recherche sur Google.

Le problème avec cette approche est qu’on assume que toutes les informations repérées par Google sont valables. Ce ne sont évidemment pas tous les sites disponibles sur le web qui sont crédibles, comme le soulignaient en 2022 des scientifiques du Royaume-Uni dans un article résumant les étapes de vérifications d’une IA. Par exemple, Originality.ai citait des informations trouvées sur le forum de discussion du site Chess.com, une source qui ne serait pas considérée comme suffisamment crédible par un journaliste.

Google propose toutefois une solution: son outil Google Fact Check est un moteur de recherche qui ne renvoie que les résultats provenant d’une organisation de vérification de faits reconnue par Google. Ainsi, lorsque le Détecteur de rumeurs a testé l’allégation sur les feux de forêt canadiens, l’application l’a dirigé vers PolitiFact et le USA Today (qui a une équipe de vérification des faits). Par ailleurs, ClaimBuster complète sa recherche en citant les résultats de Google Fact Check.

Expliquer comment on en est arrivé à un verdict

Reste un dernier point. Même si la réponse est correcte, il est souvent important, lorsqu’on fait le travail de vérification des faits, de préciser comment le verdict a été rendu —par quelle démarche, ou en se basant sur quelles sources, et pourquoi. Plusieurs IA ne le font pas, déploraient les chercheurs de Zurich.

Certaines applications vont au moins offrir le titre des sources retenues, accompagné de l’URL et d’un extrait pertinent. Ces informations peuvent donner du contexte, mais ne constituent pas en soi un argument, soulignaient les auteurs britanniques.

Est-ce que ça marche?

En 2023, le chercheur de l’Université du Wisconsin cité plus haut avait demandé à ChatGPT, à Gemini (alors Bard) et à Bing AI de vérifier 100 allégations qui avaient déjà été évaluées par des journalistes spécialisés en vérification de faits. Il avait ensuite comparé leur verdict à celui de PolitiFact et Snopes. ChatGPT 4.0 a obtenu la meilleure note avec 71 %. La moyenne des agents conversationnels n’était que de 65 %.

La même année, une équipe suisse est arrivée à des résultats similaires. Ils ont soumis 21 152 énoncés à ChatGPT. Il a réussi à déterminer si l’affirmation était vraie ou fausse dans 69 % des cas.

Dans son étude de 2024, l’équipe de Zurich citée plus haut avait pour sa part évalué les habiletés de vérification de GPT 3.5 et GPT 4 après les avoir entraînés avec une base de données spécialisée constituée d’allégations testées par PolitiFact. Résultat: GPT 4 était plus efficace que GPT 3.5, mais les résultats étaient meilleurs pour les allégations fausses, surtout les mensonges éhontés. Autrement dit, les agents conversationnels avaient plus de difficultés à vérifier une affirmation vraie ou ambiguë. Cela signifie que ces modèles d’IA ne saisissent pas les subtilités et le contexte d’une allégation. Les journalistes, eux, comprennent les nuances d’une allégation, en plus de corroborer l’information avec plusieurs sources.

À l’exception de Google Fact Check et de ClaimBuster — qui s’appuient sur le travail des humains vérificateurs de faits — les applications testées par le Détecteur de rumeurs ont effectivement donné des résultats décevants, voire plusieurs erreurs.

Verdict

Les agents conversationnels ont un potentiel pour vérifier certaines informations fausses, mais sont limités par les bases de données sur lesquelles ils s’appuient, et par leurs propres tendances à « inventer » des réponses. Même les plus efficaces de ces modèles sont encore loin derrière les vérificateurs humains.